| Student | Patrick Richter |

|---|---|

| Thema | Entwicklung eines kamerabasierten Evaluierungsverfahren für Fahrerassistenzsysteme mit autonomen Notbremseingriff |

| Bearbeitungszeitraum | 01.10.2015 – 29.02.2016 |

| Betreuer |

Prof. Dr. rer. nat. Toralf Trautmann Prof. Dr.-Ing. Kai Bruns |

– Artikel wird noch vervollständigt – Stand 26.01.2017 –

Aufgabenstellung und Zielsetzung

- Untersuchung der Möglichkeiten und Herausforderungen der videobasierten Prüfung von Notbremsassistenzsystemen auf einem Rollenprüfstand

- Gewählter Ansatz soll Anbringung der Prüftechnik so einfach wie möglich gestalten

- Geringer Kostenaufwand, sowie geringe Berechnungszeit ist anzustreben (weiche Echtzeit, bis 5 FPS)

Sensorik

In Fahrzeugen werden verschiedene Sensoren eingesetzt, die auf den grundlegenden physikalischen Gegebenheiten basieren. Derartige Sensoren werden in Fahrzeugen eingesetzt, um die Umwelt wahrzunehmen und die gewonnen Daten in die Fahrzeugsicherheit- und Assistenzsysteme einfließen zu lassen. Die eingehenden Daten werden mithilfe von Mikrocontrollern und Computersystemen verarbeitet, sodass dem Fahrer entsprechende Informationen gegeben werden, oder autonome Eingriffe in die Fahrt durch Sicherheitssysteme erfolgen können. Für den gegebenen Anwendungsfall werden Sensoren eingesetzt, welche die Umgebung vor dem Fahrzeug in Fahrtrichtung in ausreichender Reichweite (Distanz) wahrnehmen können. Vor allem die Anforderung an eine ausreichende Sensorreichweite führt dazu, dass einige Sensorsysteme nur eingeschränkt für unterschiedliche Fahrsituationen einsetzbar sind. Die verschiedenen Fahrsituationen sind dabei von variierenden Umwelteinflüssen, wie Licht, Wetter und Verschmutzung, und von den fahrdynamischen Situation des Fahrzeugs, wie Kurvenfahrten, abhängig.

Kameras

Optische Kamerasysteme stellen unter den eingesetzten Systemen den komplexesten Ansatz dar. Klassische optische, digitale Kameras besitzen im wesentlichen einen Bildsensor und ein Objektiv, welche die Aufnahme der Umgebung beeinflussen. Dabei fallen Lichtstrahlen durch das Objektiv auf den Bildsensor, wo sie sich im besten Fall fokussieren und ein physikalisches Pixel treffen auf dem sie Helligkeitsinformationen (Reflektionsverhalten des abgebildeten Objektes) hinterlassen.

Die Gesamtmenge aller Pixel des Bildsensors und deren physikalische Anordnung erzeugt ein zweidimensionales Bild der realen Szene. Der Bildsensor kann daraufhin ausgelesen und die Daten der einzelnen Pixel in digitaler Form auf einem digitalen Speichermedium festgehalten werden, wie auf Festplatten, SD-Karten, oder dem Arbeitsspeicher eines Computers.Detail

- Innerer photoelektrischer Effekt

Die Grundlage zum Verständnis für das Funktionsprinzip moderner Kameras ist der Aufbau von Bildsensoren und deren Nutzung des inneren photoelektrischen Effekts.

Bildsensoren bestehen aus einem Halbleiter-Material, wie z.B. Silizium, auf dem einzelne einheitlich große Flächen, die Pixel, strukturell abgegrenzt sind (s. Abbildung 4). Idealerweise besteht zwischen den einzelnen Pixeln keine elektrische Verbindung, sodass jedes einzelne Pixel elektrische Ladungen aufnehmen und speichern kann. Die elektrische Ladung entsteht im Idealfall durch die Wechselwirkung des Halbleitermaterials mit einem Photon, wodurch jeweils ein freies Elektron „entsteht“.

Typischerweise bestehen Bildsensoren aus p-dotiertem Silizium, was bedeutet, dass die freien Elektronen (Minoritätsladungsträger) im Potentialtopf gespeichert und ausgelesen werden. Sie stellen das Nutzsignal dar. Die dadurch über eine bestimmte Zeit (Belichtungszeit) entstandene elektrische Ladung kann nun anhand von signalverarbeitender Elektronik ausgelesen und gemessen werden (analog, stetig). Durch einen Analog-Digital-Wandler (AD-Wandler) werden abschließend aus dem analogen Signal digitale Werte erzeugt (diskret). Typische Wertebereiche sind 8 Bit (256 Helligkeitsstufen) und 16 Bit (65565 Helligkeitsstufen) je Pixel. - Laufzeitproblem

Die Daten (Menge der Helligkeitswerte aller Pixel), die von einer Kamera gewonnen werden, besitzen einen enormen Informationsgehalt, sind aber nicht ohne weiteres eindeutig auszuwerten. Der hohe Informationsgehalt eines Kamerabildes ist durch die typische große Anzahl von Pixeln gegeben, von denen durch die intrinsischen Kameraparameter zwar bekannt ist aus welcher Richtung (gesehen vom Brennpunkt) sie Licht aufnehmen, jedoch sind die Informationen über die Entfernungen der Reflektionsquelle der Lichtstrahlen, und damit der abgebildeten Objekte, verloren gegangen. Diese Zusammenhänge müssen also durch die computergestützte Auswertung der digitalen Bildinformationen zurückgewonnen, oder geschätzt werden. In der Fahrzeugtechnik bedient man sich oft Verfahren der Computer Vision, um Informationen aus dem Bildmaterial zu extrahieren, wie z.B. die Segmentierung11 von interessanten Objekten (z.B. Fahrzeugen) gegenüber der Szene, Entfernung zu solchen Objekten (Rückgewinnung von Tiefeninformationen), oder der Klassifizierung von Objekten (z.B. Fußgänger-, Fahrspur-, Fahrzeugerkennung).

Beim Einsatz von Verfahren zur Bildauswertung in Fahrzeugen muss jedoch immer die Berechnungszeit der Verfahren beachtet werden. Durch die Komplexität von zweidimensionalen Bildern ist zum Teil mit einem hohen rechnerischem Aufwand und damit hohen Laufzeiten zu rechnen, was mitunter dazu führt, dass leistungsstarke Rechentechnik in die Fahrzeuge verbaut werden muss. Auch dann muss die mögliche lange Antwortzeit (Laufzeit von Signalaufnahme bis Ergebnis vorliegt), durch den hohen Berechnungsaufwand der Auswertung eines in Echtzeit aufgenommenen Kamerabildes, beachtet werden. - Rauschen

Weitere Störungen des Bildes werden durch das Signalrauschen erzeugt. Rauschen ist im Allgemeinen eine Überlagerung des Nutzsignals (freie Elektronen) mit dem Rauschen als Störsignal. Das Signalrauschen unterteilt sich in zwei verschiedene Rauschanteile, welche sich in ihrem Entstehungsort und Auswirkungen auf das Bild unterscheiden. Der erste und bei modernen Bildsensoren am stärksten auftretende Rauschanteil ist das Dunkelrauschen, welches sich wiederum in thermisches Rauschen und Ausleserauschen unterteilt.

Der zweite und weniger hervortretende Rauschanteil ist das Photonenrauschen und spielt in den meisten Anwendungsfällen eine untergeordnete Rolle. Das Photonenrauschen entsteht durch eine nicht konstante Anzahl ankommender Lichtquanten in einem konstanten Zeitraum (Schwankung der Photonenanzahl). Dies ist aber nur in lichtschwachen Anwendungsszenarien von Bedeutung. - Monovision und Stereovision

Beim Einsatz von Kameras in Fahrzeugen wird versucht möglichst viele und vereinfachte Informationen aus den komplexen Bildern zu berechnen. Die Daten sollen im Falle des Notbremsassistenten Informationen, wie die Position und den Abstand zum vorausfahrenden Fahrzeug, enthalten, um berechnen oder schätzen zu können ob und mit welcher Stärke ein Bremseingriff erfolgen muss.

Oft werden dabei zwei verschiedene Strategien verfolgt. Ein Möglichkeit den Abstand zu vorausfahrenden Fahrzeugen zu schätzen ist der klassische Einsatz einer Kamera (Monovision) an der Fahrzeugfront, die den vorausfahrenden Verkehr beobachtet. Dabei wird versucht Fahrzeuge im digitalen Bild zu finden und die Umrisse des Fahrzeuges herauszustellen. Gelingt dies, kann der Abstand zum gefundenen, vorausfahrenden Fahrzeug grob geschätzt werden. Je nach verwendetem Verfahren kann diese Schätzung recht genau erfolgen.

Ein genauerer Ansatz ist die Verwendung von zwei Kameras, die als Stereokamerapaar angeordnet sind und ebenso den vorausfahrenden Verkehr beobachten. Das Prinzip ist an das menschliche Sehen mit zwei Augen angelehnt und nutzt die Parallaxe zum Bestimmen von Entfernungen.

Lidar

Ein Lidar ist die Abkürzung für Light Detection and Ranging und bezeichnet den Einsatz eines Lasersystems, um genaue Distanzen zu Objekten mithilfe von Licht zu bestimmen. Häufig ist das Lasersystem dadurch gekennzeichnet, dass nur eine bestimmte Anzahl an Winkelpositionen, also Distanzen in bestimmten Winkelabständen, erfasst werden können, wobei die Erfassung meist nur in der horizontalen Ebene erfolgt. Ein Lidar ist außerdem durch eine bestimmte maximale Aufnahmefrequenz gekennzeichnet, mit der die Szene erfasst werden kann (vgl. Bildwiederholrate). Nicht selten liegt die Bildwiederholrate unterhalb der einer optischen Videokamera.

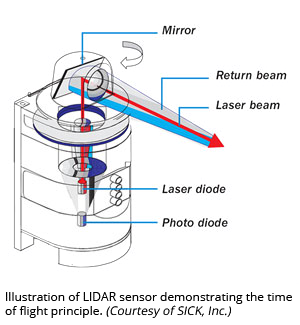

Der Lidar besteht aus der technischen Sicht, wie sie in der Abbildung zu sehen ist, aus einer einfachen Laserdiode (Laser Diode), einem Umlenkspiegel (Mirror) und einer Fotodiode (Photo Diode).

Aufbau eines Lidar-Sensors (Angelehnt an Quelle: SICK, Inc.)

Detail

- Funktionsprinzip

Der durch die Laserdiode emittierte Laserstrahl wird an dem Umlenkspiegel um 90° abgelenkt und tritt in den Raum. Dort wird er von einem Objekt in bestimmter Entfernung (diffus) reflektiert. Die reflektierten, abgeschwächten Lichtstrahlen (Return Beam) werden nun am Lidar wieder aufgenommen und mit einer Fotodiode detektiert. Die Zeit, die seit dem Aussenden des Lichts durch die Laserdiode und dem Empfangen durch die Fotodiode vergangen ist, wird nun zur Berechnung des vom Licht zurückgelegten Weges benutzt. Das System des Lidar muss dabei sehr kleine Zeitunterschiede im Pikosekundenbereich (Billionstel Sekunden) auflösen können, um eine Genauigkeit der Distanzbestimmung von einigen Millimetern bis Zentimetern zu erreichen.

Zur Erfassung mehrerer Richtungen in horizontaler Ebene dreht sich der Umlenkspiegel um seine Horizontalachse, sodass eine theoretische Erfassung der Entfernungen um 360° in horizontaler Ebene möglich ist, wenn es die konstruktiven Merkmale des Gehäuses und die Montage am Fahrzeug erlauben. Je nach Drehgeschwindigkeit des Umlenkspiegels dauert die Erfassung (Erfassungszeit) der Distanzen der gesamten Umgebung in horizontaler Ebene solange wie der Spiegel für eine Umdrehung benötigt. Zwar verringert die Einschränkung des Erfassungswinkels von 360° auf beispielsweise 180° die theoretische Erfassungszeit eines Bildes auf die Hälfte einer ganzen Umdrehung, jedoch muss der Spiegel weiterhin den Rest der Drehung vollziehen, um wieder am Startwinkel der Erfassung anzukommen. Damit verbleibt die Erfassungszeit von 180° konstant mit der von 360° Erfassungswinkel. Somit ist lediglich die Drehgeschwindigkeit des Umlenkspiegels das ausschlaggebende mechanische Kriterium für die Wiederholrate. - Einschränkungen

Durch alle vorgestellten Parameter wird deutlich, dass der Betrieb eines Lidar immer ein Kompromiss aus Wiederholrate, räumlichen Winkelauflösungsvermögen und aus wirtschaftlicher Sicht vor allem aus den entstehenden Kosten ist, da das System durch die Ausnutzung der Lichtgeschwindigkeit eine sehr hohe zeitliche Auflösung und somit exakt arbeitende und teure Komponenten benötigt.

Darüber hinaus ist das Messprinzip mit Licht einigen materialbedingten Fehlern unterworfen. Sehr stark lichtabsorbierende Oberflächen und hochgradig transparente Werkstoffe verfälschen die Distanzmessung, sodass die eigentliche Zielstellung, die Distanz zum räumlich nahsten Festkörper in Richtung des Lichtstrahls zu messen, nicht für alle Materialien erfüllt werden kann. Außerdem sind Lidar, ebenso wie optische Kamerasysteme, wetterbedingten Einschränkungen unterworfen. Sie reagieren zwar weniger empfindlich auf Gegenlicht, jedoch werden sie im Besonderen durch Regen- und Schneefall eingeschränkt.

Radar

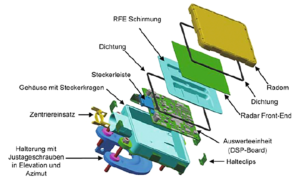

Die Radar-Technologie (Radio Detection And Ranging) ist heute bei Fahrzeugen mit Notbremsassistent weit verbreitet. Seinen Ursprung hat diese Technologie in der Militärtechnik zur Bestimmung von Distanzen zu Flugkörpern. Die Automobilindustrie nutzt die Technologie auf ähnliche Weise. Durch einen entsprechenden Radar-Sensor, wie er in der nachfolgenden Abbildung vom Unternehmen Hella beispielhaft zu sehen ist, können vorausfahrende Fahrzeuge detektiert und der Abstand zu ihnen ermittelt werden. Der Sensor funktioniert im wesentlichen durch das Aussenden von gebündelten elektromagnetischen Wellen (Radiowellen) in Form eines Impulses, der Reflektion dieser an einem Objekt und der Aufnahme der Impulsantwort (reflektierte Radiowellen). Daraufhin werden die gewonnen Messergebnisse, wie die Laufzeit und Frequenz der Impulsantwort, ausgewertet und so Distanzen und Winkelpositionen zu vorausfahrenden Fahrzeugen, Passanten, oder allgemeinen Hindernissen berechnet.

Explosionsdarstellung des Hella-ACC-Radars (Quelle: Hella)

Detail

- wird ergänzt

- Innerer photoelektrischer Effekt

Verwandte Projekte und Verfahren

Verwandte Projekte

Es existieren einige Projekte, die sich dem maschinellen Sehen bedienen, um vorausfahrende Fahrzeuge zu erkennen. Das Interesse ist groß, da der Konkurrenzkampf in der Automobilindustrie hoch ist und neue innovative Systeme für einen besseren Absatz eines Fahrzeugmodells sorgen. Darüber hinaus werden Systeme, welche die Sicherheit der Fahrzeuginsassen erhöhen in der Regel in der Öffentlichkeit als sehr positiv wahrgenommen. In diesem Abschnitt werden dem Thema dieser Arbeit entsprechend einige passende Projekte, bzw. bekannte Ansätze, grob vorgestellt.

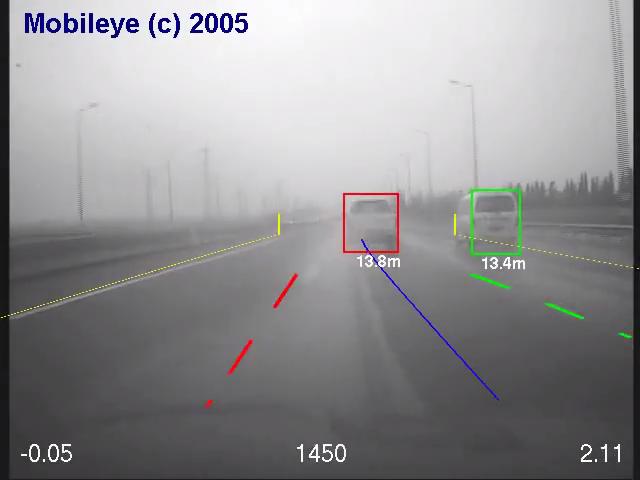

Die meisten bewährten Ansätze auf Basis von Radar- und Lidar-Sensoren sind als klassische Ansätze zu verstehen. In dieser Arbeit geht es jedoch u.a. um die Detektion und Abstandsmessung zu vorausfahrenden Fahrzeugen mithilfe einer Kamera. Die nachfolgend vorgestellten verwandten Projekte sind zwei sehr bekannte Beispiele für die Integration von Kamerasensorik um ein Fahrzeug teil- oder vollständig autonom auf die Umgebung reagieren zu lassen.Das System zur Abstandsbestimmung zu vorausfahrenden Fahrzeugen des, im Rahmen dieser Arbeit untersuchten, BMW i3 nutzt die entwickelte Soft- und Hardware eines unabhängigen Unternehmens, die in ähnlicher Form u.a. auch schon in LKWs von Volvo eingesetzt wurde (Volvo CWAB). Das System wurde von dem Unternehmen Mobileye entwickelt und in Form einer eigenständigen Hardware, mit Schnittstelle zum Datensystem des PKW, als Mikroprozessor EyeQ und EyeQ² vermarktet. Das Unternehmen bietet u.a. Softwarefunktionalitäten wie Spur-, Fahrzeug-, Fußgänger- und Verkehrsschilderkennung an (siehe nachfolgende Abbildung). Das System nutzt zur Beobachtung des vorausfahrenden Verkehrs eine Kamera und wertet den aufgenommenen Bildbereich mit Software-Algorithmen aus. Große Teile der dafür verwendeten Prinzipien sind bekannt, jedoch legt Mobileye die verwendeten Algorithmen und Parameter zur Anpassung selbstverständlich nicht offen.

Fahrzeug- und Spurerkennung von Mobileye (2005) (Quelle: Einzelbild aus Video von http://www.mobileye.com/technology/applications/vehicle-detection/forward-colision-warning/)

Ein anderes Projekt ist die DARPA-Challenge, welche unregelmäßig von einer Außenstelle des US-amerikanischen Verteidigungsministerium organisiert wird. DARPA ist die Defense Advanced Research Projects Agency, welche teils militärische Ziele verfolgt und mit den organisierten „Challenges“ Industrie und Forschung weltweit zur Teilnahme an Herausforderungen anregt. Von besonderem Interesse für diese Arbeit ist die DARPA Urban Challenge, die im Jahr 2007 ausgetragen wurde. Die Aufgabe der teilnehmenden Teams war es ein Fahrzeug vollständig autonom durch einen 93 km langen Stadt-Parcours zu bewegen und eine bestimmte vorgegebene Strecke mit Hindernissen zu absolvieren und das Ziel zu erreichen. Die teilnehmenden Teams statteten die Fahrzeuge, neben anderer Sensorik, auch mit Kameras aus, deren Bildmaterial in Echtzeit ausgewertet wurde.

Neben den beiden sehr bekannten Beispielen gibt es noch eine Vielzahl von Arbeiten der Grundlagenforschung zur Erkennung von Fahrzeugen in bewegten und unbewegten Kamerabildern, wie z.B. mithilfe von Knowledge-Based Methods (Symmetrie, Farbe, Schatten, Ecken, Kanten, Textur und Fahrzeugbeleuchtung), Stereo-Vision-Based Methods (Disparity Map und Inverse Perspective Mapping) und Motion-Based Methods. Woraufhin meist eine Absicherung der gefundenen, möglichen Fahrzeuge durch Template-Based Methods und Appearance Methods erfolgt.Verwandte Verfahren

Im Rahmen der Computer Vision wird häufig versucht Informationen über eine reale dreidimensionale Szene aus der zweidimensionalen Abbildung dieser ursprünglichen Szene zurückzugewinnen. Das ist nötig, da durch die Projektion der realen Szene Größen (vgl. Informationen) transformiert und in einer Abbildung, mit weniger Informationsgehalt, resultieren. Man spricht in diesem Zusammenhang von Linearer Transformation und beschreibt den Informationsgehalt verschiedener Transformationsgruppen. Bereits der Fakt, dass die durch Projektion erfasste reale Szene von drei Raumdimensionen auf zwei Dimensionen reduziert wird impliziert den Informationsverlust.

Die gewünschten Informationen können aus der Abbildung, bis hin zur vollständigen Rekonstruktion aller Informationen der realen Szene, durch die Analyse des gegebenen Bildmaterials erfolgen. Dafür werden Invarianten durch bekannte Größen eingeführt und somit Freiheitsgrade beseitigt.

Marker Recognition

Die Marker Recognition (vgl. „Marker Detection and Tracking“) ist ein Verfahren in der Computer Vision um definierte und optisch gut zu unterscheidende Marker in einem Bild zu finden und verschiedene Eigenschaften, die den Markern entnommen werden können, auszuwerten. Dazu zählen relative Eigenschaften wie Translation, Rotation, und Größe der Marker im zweidimensionalen Bild. Um Marker für die Distanzbestimmung zu nutzen, ist es nötig die relative Größe eines Markers, oder die relativen Abstände mehrere Marker zueinander zu bestimmen. Dabei muss die absolute Größe des Markers, oder der absolute Abstand der Marker zueinander bekannt sein. Aufgrund der bekannten absoluten Größen im Verhältnis zu den relativen Größen, kann eine zuverlässige Aussage über die absoluten Distanzen gemacht werden.

Stereo Vision

Im Gegensatz zu der Distanzbestimmung durch Marker nutzt man bei der Stereo Vision die Disparität zweier Kameras ([17] S. 415ff.). Beide Kameras können zueinander beliebig ausgerichtet sein. Die überschneidenden Gesichtsfelder ergeben einen gemeinsam sichtbaren Bereich, der für die Ermittlung von Invarianten von Bedeutung ist.

Mit der Anwendung eines gerichteten Stereokamerapaar versucht man in der Regel annähernd das Prinzip des natürlichen Stereosehens nachzuahmen (vgl. menschliches Augenpaar). Das heißt, dass die Kameras in einem definierten Abstand zueinander fixiert sind und gemeinsam in eine definierte Richtung „blicken“. Im Fall des menschlichen Sehens kreuzen sich die optischen Achsen der Kameras (vgl. Augen) und sind auf ein Objekt im Raum gerichtet, sodass sie auf einen gemeinsamen Punkt fixiert sind. Durch die unterschiedlichen Winkelausrichtung beider Augen kann die Entfernung zum fixierten Objekt approximiert werden, wobei der fixierte Punkt bei der Überlagerung der Bilder beider Augen theoretisch an den gleichen Bildkoordinaten abgebildet werden. Umso weiter entfernt ein fixiertes Objekt ist, desto mehr nähern sich die optischen Achsen der Augen einer parallelen Ausrichtung an. Dieses Verhältnis wird Parallaxe genannt. Im Gegensatz zum menschlichen Auge nutzen die meisten Stereokameras das Prinzip der parallelen Ausrichtung der optischen Achsen, sodass sich die optischen Achsen im Unendlichen schneiden, wodurch unendlich weit entfernte Objekte in beiden Kameras auf den gleichen Bildkoordinaten abgebildet werden. Die Abbildung naher Objekte wird jedoch maßgeblich durch eine scheinbare Verschiebung zwischen beiden Kamerabildern bestimmt. Der Effekt der Parallaxe tritt ein, indem ein Objekt in beiden Bildern auf unterschiedlichen Bildkoordinaten abgebildet wird, woraus sich bestimmbare Winkelabweichungen ergeben.

Konzeptionierung der Lösung

Die Distanzmessung erfolgt aus technischer Sicht traditionell mit dafür konzipierten Messgeräten. Solche Messgeräte basieren vor allem auf den im Kapitel 2.3 erwähnten Technologien basierend auf Radar-, Laser-, und klassischer Kameratechnik. Vor allem die Distanzmessung mit Kameras erfolgt meist mit zwei Kameras, die wie das menschliche Augenpaar gerichtet in eine Richtung schauen und sich die Disparität zu Nutze machen, um absolute (real räumliche) Distanzen zu Objekten zu berechnen.

Über diese klassischen Ansätze hinaus gibt es noch zwei Möglichkeiten mit nur einer Kamera absolute Distanzen zu bestimmen. Der erste Ansatz nutzt das Verhältnis von mindestens einer absoluten zu einer relativen Größe. Beide veränderliche Größen müssen dabei jedoch ein Proportionalitätsverhältnis zueinander aufweisen, also immer im selben Verhältnis zueinander stehen. Ein anwendungsbezogenes Beispiel dafür ist das Verhältnis der relativen, abgebildeten Breite der Rückseite eines vorausfahrenden PKW zu der absoluten, realen Distanz zur Rückseite des vorausfahrenden Fahrzeugs. Das so gebildete Verhältnis kann mithilfe der Mathematik und Projektion auf den Strahlensatz übertragen werden, der im Fall der Projektion aussagt, dass sich die zwei veränderlichen Größen (absolute Distanz, relative Abbildungsgröße) umgekehrt proportional zueinander verhalten.Einführung von normierten Markern

Für die Bestimmung der Abstände wird jedoch im Gegensatz zu dem genannten Kapitel nicht die Größe der Marker beachtet, sondern mehrere, definiert angeordnete Marker verwendet. Dabei wird stets versucht die Mittelpunkte der Marker (fortan allgemein als Position bezeichnet) so genau wie möglich zu bestimmen. Als Anordnung können zum Beispiel zwei Marker vertikal oder horizontal angebracht und die relative Distanz zwischen den beiden Markern bestimmt werden. Das hat den Vorteil, dass größere relative Pixelabstände in der digitalen Abbildung (vgl. Einzelbild einer Videoaufnahme) zwischen den absoluten, physikalischen Zentren der Marker erreicht werden können, als bei der Messung der Projektionsgröße eines scheinbar kleineren einzelnen Marker. Größere relative Pixelabstände resultieren wiederum in einer genaueren Bestimmung der absoluten Distanz, da das Auflösungsvermögen der digitalen Abbildung besser ausgenutzt wird. Es muss lediglich darauf geachtet werden, dass die Anordnung der Marker auf der Fahrzeugrückseite so gewählt wird, dass die Marker beim kleinstmöglichen Abstand noch in das Sichtfeld der Kamera passen. Das kann erreicht werden, wenn entweder die Anordnung der Marker entsprechend verändert, oder die Brennweite des Kameraobjektivs so gewählt wird, dass die gesamte Anordnung der Marker das Bild sinnvoll ausfüllen.

Konzeption: Gradient-based Pattern Finding Algorithmus (GPF)

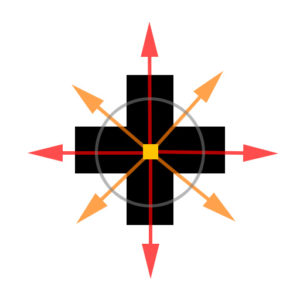

Beim GPF wird versucht den normierten Marker im gesamten Bild mithilfe von Helligkeitsverläufen (Gradienten) zu finden und dessen genaue Position zu bestimmen.

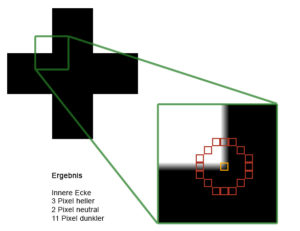

Gradient-based Pattern Finding

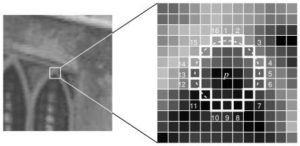

Dabei werden zunächst mögliche Zentren der abgebildeten Marker gesucht, indem dunkle, entsättigte Pixel auf benachbarte hellere, entsättigte Regionen (vgl. Diagonalen des Kreuzmusters) geprüft werden (Diagonalenprüfung). Dabei müssen ausgehend vom möglichen zentralen Pixel alle benachbarten diagonalen Gradienten die gleiche Länge aufweisen, also der Abstand zwischen möglichem zentralen Pixeln und den Bildkoordinaten bei denen der Helligkeitszuwachs (Gradient) groß genug war, um als helle Region zu gelten.

Ist die Gradientenprüfung erfolgreich gewesen, müssen nachfolgend auch die Horizontalen und Vertikalen geprüft werden (Achsparallelenprüfung). Ausgehend vom ermittelten möglichen Zentrum, müssen sie ähnliche Pixelhelligkeiten und Sättigung aufweisen wie das ermittelte mögliche zentrale Pixel. Dafür werden nur die Pixel geprüft, die um die einheitliche Länge der Diagonalenprüfung vom Zentrum entfernt sind (siehe obere Abbildung).Ist die Diagonalen- und Achsparallelenprüfung erfolgreich erhält man in der Regel mehrere mögliche Zentren innerhalb eines im Bildfeld abgebildeten Markers. Diese möglichen Zentren werden nun zusammengefasst, wenn sie direkt benachbart sind. Eine direkte Nachbarschaft ist definiert durch alle Pixel welche die Kanten oder Ecken eines zentralen Pixels berühren. Es werden folglich alle möglichen Zentren als zusammengehörig markiert, die sich innerhalb dieser direkten Nachbarschaftsbeziehung zueinander befinden. Für die Zusammenfassung und damit Eliminierung aller markierten zusammengehörigen Zentren wird die Position des nun ermittelten echten Zentrums über das arithmetische Mittel subpixelgenau berechnet. Mit zunehmender Anzahl der zur Mittelung herangezogenen zusammengehörigen Zentren steigt die mögliche Subpixelgenauigkeit an.

Bestimmung von möglichen Zentren (Rot, Türkis, Grün, Gelb) und anschließende Mittelung zum echten Zentrum mit Subpixelkoordinaten (Blau)

Konzeption: Feature-based Pattern Finding Algorithmus (FPF)

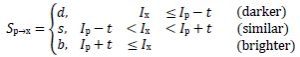

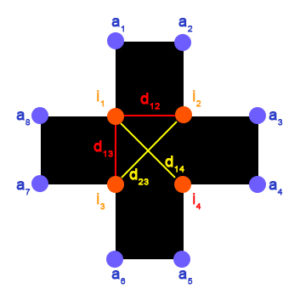

Ähnlich dem GPF nutzt das FPF die Helligkeitsverläufe des kreuzförmigen, normierten Markers, durch den Einsatz von FAST Features. FAST ist ein besonders schnelles und effektives Verfahren, um Kanten, bzw. Ecken von abgebildeten Objekten im Bildfeld zu finden.

Der Algorithmus vergleicht die Intensität (Helligkeitswert) eines zu untersuchenden, zentralen Pixels und dessen kreisförmige Umgebung bestehend aus 16 Pixeln (siehe Abbildung: Prinzip von FAST Features) mithilfe eines einfachen Vergleichs der Intensitäten (siehe folgende Formel).

FAST Feature Entscheidungsbaum

Prinzip von FAST Features

Im Fall der eingesetzten normierten Marker kann durch die Klassifikation und ihre Zähler bestimmt werden, ob es sich um eine außenliegende (hellere Pixel überwiegen) oder eine innenliegende Ecke (dunklere Pixel überwiegen) handelt, wie in nachfolgender Abbildung verdeutlicht.

Beispielhafte Anwendung von FAST auf den normierten Marker während der Laufzeit

Die nun geschaffene Basis aus FAST Features und die dadurch ermöglichte eindeutige Bestimmbarkeit von außen- und innenliegenden Ecken kann nun dazu genutzt werden, die normierten Marker anhand der charakteristischen Anordnung ihrer Ecken im Bildfeld zu finden.

Für die Erhöhung der Genauigkeit werden weitere Mittelpunkte aus den äußeren Punkten 1,2,5,6 und 3,4,7,8 erzeugt, welche nah am vorher aus den inneren Ecken erzeugten Mittelpunkt liegen. Die so erhaltenen drei Mittelpunkte haben die gleiche Subpixelgenauigkeit, da sie jeweils aus vier Eckpunkten erzeugt wurden. Die Bildung des einfachen arithmetischen Mittels aus den drei Mittelpunkten mit einer Subpixelgenauigkeit von je 1/4 ergibt einen Mittelpunkt mit einer theoretischen Gesamt-Subpixelgenauigkeit von 1/12 Pixel.

Logische Identifizierung von Markern mithilfe von FAST Features (FPF Algorithmus)

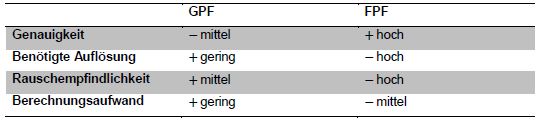

Kurze Gegenüberstellung beider Verfahren

Zusammenfassend ist das FPF also dann zu bevorzugen, wenn das Kamerasystem nur wenigen Störeinflüssen unterliegt und über eine hohe Auflösung verfügt, da es die genaueren Ergebnisse liefert. Jedoch geht die höhere Genauigkeit in Gegenüberstellung zum GPF mit einer ebenso höheren Berechnungszeit einher. Das GPF sollte somit dann eingesetzt werden, wenn die Genauigkeit der Ergebnisse nicht sehr hoch sein muss und die Ausgangsbedingungen durch hohes Bildrauschen und eine geringere Auflösung schlechter sind.

Übersicht der Vor- und Nachteile von GPF und FPF

Zeitliche Synchronisation der Videodaten

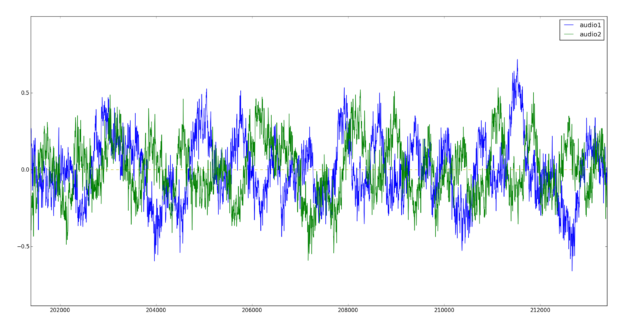

Beim angestrebten Einsatz von zwei Kameras, zur zeitgleichen Erfassung der Prüfmaske und den Signalen des Fahrzeugs, ist es nötig beide voneinander unabhängig aufgenommene Videodaten zeitlich zu synchronisieren, sodass die Signale des Fahrzeuges zeitlich mit den ermittelten Abständen zur Prüfmaske übereinstimmen. Dadurch soll eine korrekte Auswertung der Daten sichergestellt werden. Neben den in der Arbeit erläuterten visuellen Ansatz wird hier nur der akustische Ansatz dargestellt.

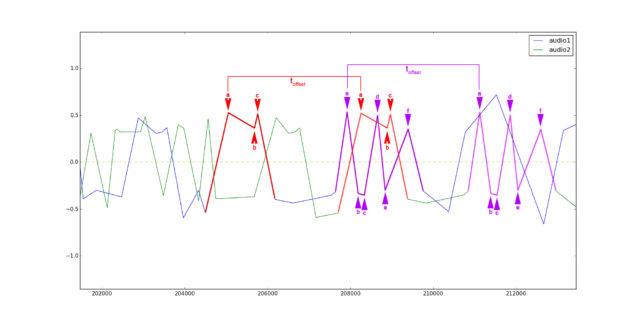

Im Gegensatz zur visuellen Synchronisation von Videodaten nutzt die im folgenden konzipierte akustische Synchronisation (vgl. Audio-Synchronisation) eine mit den Videoaufnahmen zusammen aufgenommene Tonspur. Die Tonspuren enthalten theoretisch sich ähnelnde akustische Abschnitte, die gegeneinander um das Offset offset zeitlich verschoben in jeder der beiden Tonaufnahmen aufgetreten sind. Ein zur Synchronisation geeigneter akustischer Abschnitt ist ein mehrere Millisekunden langes Audio-Sample, welches eindeutig zu beschreiben ist und über die gesamte zeitliche Länge der Tonaufnahme vorzugsweise einmalig auftritt. Ein eindeutig zu beschreibendes Audio-Sample hat wiederum einen charakteristischen Amplitudenverlauf, was beispielhaft in der nachfolgenden Abbildung dargestellt wird.

Typische Audiospur mit gleichem, jedoch zeitlich verschobenem, Frequenz- und Amplitudengang (Offset; grüne Tonspur zeitlich später)

Nach der Filterung hoher Frequenzen wird für die gesamte Tonaufnahme zwischen zwei Nulldurchgängen die größte bzw. kleinste Auslenkung, ein Extrempunkt, gesucht. Der Extrempunkt stellt ein Feature der Tonaufnahme dar und enthält in Nachbarschaft mit anderen Features die folgenden Informationen.

- minimale oder maximale Amplitude (Auslenkung)

- Zeit des Auftretens in der gesamten Tonaufnahme

- zeitlicher Abstand zu benachbarten Features

Zur Wiederfindung der Features in der jeweils anderen Tonaufnahme können nun diese Eigenschaften verglichen und die zeitliche Verschiebung „Offset“ offset bestimmt werden. In der nachfolgenden Abbildung ist das Wiederfinden von Features von zwei sich ähnelnden, aber zeitlich verschobenen Tonspuren dargestellt. Die für die Bildung von Features genutzten Quell-Tonspuren der Abbildung entsprechen den bereits in der obigen, vorhergehenden Abbildung gezeigten Tonspuren mit vollem Frequenzspektrum.

Audio Synchronisation – Bestimmung des Offset sich ähnelnder akustischer Abschnitte

Bei der Auswertung des zeitlichen Offset müssen jedoch Störeinflüsse wie das Signalrauschen und die Raumakustik als Störgröße beachtet werden (hier nicht weiter ausgeführt).

Implementierung und Ergebnisse

In diesem Kapitel werden die Besonderheiten implementierter Algorithmen beschrieben und geeignete Testdatensätze vorgestellt. Abschließend werden die Testergebnisse der einzelnen implementierten Verfahren in Bezug zu ihrer Robustheit, bzw. Verwendbarkeit für fortführende Analysen, bewertet. Die ausgewählten Verfahren wurden entsprechend ihrer Beschreibung, bzw. deren Konzeption als Software-Prototyp umgesetzt.

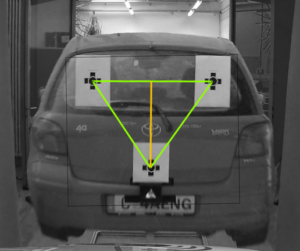

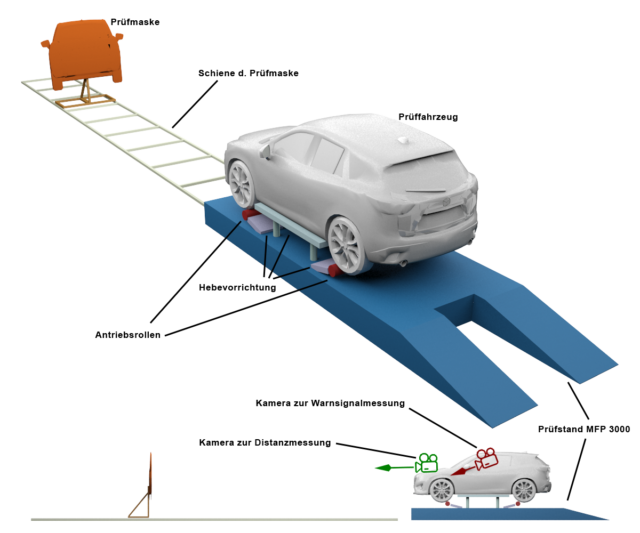

Anordnung der Prüftechnik

Ein wichtiger Bestandteil der Implementierung ist die Aufnahme der Testdatensätze, die mithilfe der vorhandenen Prüftechnik angefertigt werden. Die nachfolgende Abbildung zeigt die schematische Anordnung aller relevanten Bestandteile während der Prüfung, wie sie auch für der Aufnahme der Testdatensätze gegeben war.

Anordnung der Prüftechnik

Testergebnisse

Ziel der Arbeit war die Durchführung von Messungen mithilfe des entwickelten Prototypen und entsprechenden Testdatensätzen durch die Simulation einer Gefahrensituation mithilfe der zur Verfügung stehenden Prüftechnik. Für die Messungen auf dem Prüfstand wurde hauptsächlich das Fahrzeug A, der VW Passat CC, eingesetzt und insgesamt 16 Messungen durchgeführt. Jedoch zeigte das Fahrzeug A in drei von sechszehn Fällen keine Reaktion auf die entgegenkommende Prüfmaske, sodass diese Messungen nicht nutzbar waren. Letztendlich standen dreizehn erfolgreiche Durchgänge zur Verfügung, die im Prototypen ausgewertet werden konnten, wobei wiederum drei der dreizehn Durchgänge eine unzureichend späte Reaktion auf die simulierte Gefahrensituation zeigten.

Gegenüberstellung der Genauigkeit der implementierten Verfahren

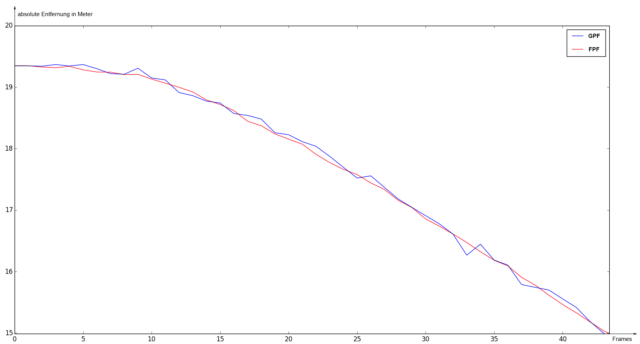

Zur Berechnung der absoluten Entfernungen der Testdatensätze wurden die eigenständig entwickelten und beschriebenen Verfahren, das Gradient-based Pattern Finding und das Feature-based Pattern Finding, genutzt. Dennoch unterliegen beide Verfahren unterschiedlicher Zuverlässigkeiten bei der Erkennung, und schwankender Genauigkeit bei der Bestimmung, der Mittelpunkte der normierten Marker, wie es bereits im Abschnitt „Gegenüberstellung der theoretischen Vor- und Nachteile beider Verfahren“ beschrieben wurde. Nach der Implementierung der Verfahren und die darauf folgende Nutzung des Prototypen mit den Testdatensätzen sind die theoretischen Vorüberlegungen bestätigt worden, was in den nachfolgenden beiden Abbildungen beispielhaft dargestellt wurde.

Gegenüberstellung der ermittelten abs. Entfernungen von GPF u. FPF

Beide Abbildungen wurden dem gleichen Testdatensatz („run3“) entnommen und stellen das GPF dem FPF direkt gegenüber. Dabei zeigte sich, dass das FPF eine wesentlich genauere Entfernungsbestimmung erlaubt als das GPF, was sich auch in einer niedrigeren Streuung der Fehlertoleranz verdeutlicht. Die höhere Genauigkeit des FPF kommt, wie bereits in den theoretischen Vorüberlegungen erläutert, durch die größere Anzahl von Markermerkmalen zur Mittelpunktberechnung zustande.

Trotz der gezeigten Vorteile des FPF ist die Zuverlässigkeit des FPF niedriger als die des GPF. Das GPF nutzt lediglich den Helligkeitsverlauf der Marker ausgehend von der Mitte der normierten Marker um potentielle Marker zu bestimmen. Sollten Details der Marker durch Störeinflüsse, Bewegungsunschärfe, oder der begrenzten Auflösung des eingesetzten Kamerasystems undeutlich abgebildet werden, so besitzt das GPF eine höhere Erkennungsrate als das FPF.

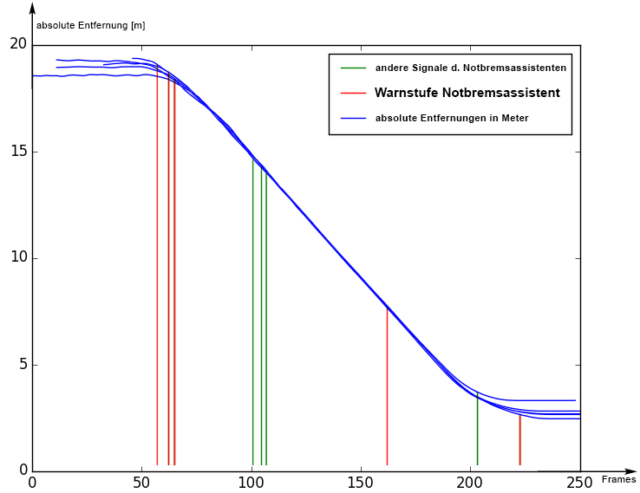

Bewertung der Notbremsfunktion

Bereits bei der Aufnahme der sechszehn Durchläufe zeigte sich, dass die Notbremsfunktion des Fahrzeugs A unregelmäßig auslöste, sodass das vorausfahrende Fahrzeug, in Form der Prüfmaske, bei nahezu gleichbleibender Geschwindigkeit manchmal nicht oder während der Annäherung nicht durchgehend erkannt wurde. Die unregelmäßige Erkennung der Prüfmaske führte dazu, dass der Notbremsassistent zum Teil nicht, oder nur sehr spät ausgelöst wurde. Diese Probleme können auch den Messergebnissen entnommen werden. In der nachfolgenden Abbildung ist zu erkennen, dass die erstmalige Erkennung der Gefahrensituation (Warnstufe) durch die entgegenkommende Prüfmaske (Rot), sowie die Auflösung der Warnung (Grün) zum Teil unregelmäßig über die Kurve der ermittelten absoluten Entfernungen verteilt ist.

Gesamtergebnis der Reaktion des Notbremsassistenten nach fünf Durchläufen (VW Passat CC)

Nach diesem Beispiel könnte ein Prüfer zu dem Schluss kommen, dass das Fahrzeug aus dem vorgestellten Beispiel die Prüfung des Notbremsassistenten nicht, oder nur mit Einschränkungen, bestanden hätte, sodass eine konkrete Überprüfung der Funktionalität in einer Werkstatt erfolgen und das Fahrzeug dem Prüfer erneut vorgestellt werden müsste. Mit dem in diesem Beispiel vorgestellten Prinzip können nun entsprechende Prüfungen beliebiger Fahrzeuge erfolgen, um zumindest die Streuung und Fehleranfälligkeit des Notbremsassistenten des Fahrzeugs zu prüfen. Die Prüfung der langfristigen Veränderung (z.B. durch Alterung) der Reaktionen des Notbremsassistenten kann wie beschrieben nur unter Zuhilfenahme einer globalen Datenbank erfolgen.

Ausblick

- Aktuell: Umsetzung verschiedener Ansätze und Ideen über die Masterarbeit hinaus als wissenschaftlicher Mitarbeiter, sowie Integration der Ergebnisse in aktuelle Forschungsthemen im Rahmen der Forschungsgruppe „NIVES“

Anhand der vorgestellten Verfahren und den prototypischen Implementierungen konnte gezeigt werden, dass geeignete Lösungen auf Basis der Computer Vision und dem Einsatz von nur einer Kamera zur Distanzmessung entwickelt werden können. Das Ergebnis ist ein Prototyp, welcher die gestellten Anforderungen erfüllt und zwei eigenständig entwickelte Verfahren in einer Software vereint, deren Aufbau an die potentielle Integration in das Tagesgeschäft von Prüforganisationen angelehnt ist.

Bei der Ausarbeitung der Arbeit wurden einige grundlegende Ansätze der Computer Vision aufgegriffen und verändert, um sie entsprechend der Problemstellung anzupassen. Dadurch konnten vor allem aus den Ansätzen der Monovision geeignete Verfahren entwickelt werden. Dazu zählt das Gradient-based Pattern Finding und das Feature-based Pattern Finding, welche auf das Wiederfinden eines normierten, rotationssymmetrischen Markers spezialisiert sind. Die so entstandene robuste Bestimmung der Mittelpunkte der Marker konnte für die Berechnung von absoluten Entfernungen mit hoher Genauigkeit genutzt werden.

Neben den für die Problemstellung gegebenen Lösungsvorschlägen existieren noch eine Vielzahl weiterer möglicher Herangehensweisen, sodass fortführende Untersuchungen in Betracht gezogen werden können.

- Kombination des GPF mit dem FPF. GPF dank geringerer Berechnungszeit zur Vorauswahl der Regionen für FPF mit höherer Genauigkeit

- Dynamisches ROI in Verbindung mit Kalman-Filter zur Eingrenzung des Suchbereichs

- Erkennung anderer Markertypen, z.B. anhand von Masken die individuell in der Software eingelesen, ausgewertet und im Bild wiedererkannt werden.

- Haar Classifier zur groben Vorauswahl der Fahrzeuge

- Nutzung natürlicher Features der Fahrzeuge als Referenz (aktuell in Bearbeitung)

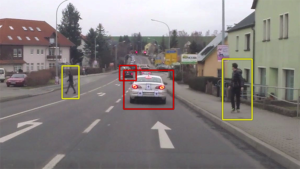

Mögliche Anwendung eines Haar Classifier zur Erkennung von Fahrzeugen (Rot) und Personen (Gelb)